Si queremos controlar el rastreo de la web (y queremos) tenemos que saber antes cómo utilizar el archivo robots.txt.

Índice de contenidos

Qué es el archivo robots.txt

Este documento es un mensaje directo que va dirigido a Google y a cualquier otro motor de búsqueda o de crawleo como puede ser el de Yandex, Baidu o Screamingfrog.

Se utiliza para indicarle a Google qué contenido debería rastrear y por qué carpetas no debe pasar. El objetivo es minimizar las peticiones que le hacemos a Google. De esta forma Google pasa su tiempo rastreando páginas con contenido relevante.

El archivo se llama robots.txt porque va dirigido a los “robots” también conocidos como “arañas” que pasan por nuestra web cada cierto tiempo. Google tiene sus robots encargados de pasar por las webs en busca de páginas relevantes para el posicionamiento de palabras clave.

Por otro lado, se llama robots.txt porque es un archivo de texto. Es tan sencillo que se puede hacer con el tipico bloc de notas que viene por defecto en cualquier ordenador.

Qué contenido añadir al robots.txt

Podemos añadir todas las carpetas que no queramos que rastree Google. Queremos evitar que el sitio web sobrecargue de solicitudes de rastreo a Google, es decir, optimizar el presupuesto de rastreo.

Si detectamos algunas carpetas que no nos interesa posicionar las podemos añadir, pero recuerda que Google no quiere que utilices este fichero como método para la desindexación, ya que lo puede encontrar y posicionar si están enlzadas.

No uses robots.txt para ocultar una página web de los resultados de la Búsqueda de Google, ya que, si otras páginas apuntan a esa página con texto descriptivo, es posible que se indexe aunque no se visite

Soporte de Google

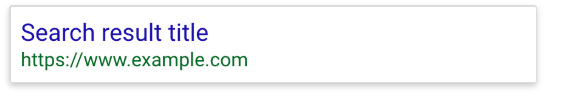

Si quieres desindexar una página, lo ideal es que utilices la etiqueta “no index” dentro de estas páginas para ocultarlas del todo. Si no podrían seguir mostrándose con un resultado muy similar a este:

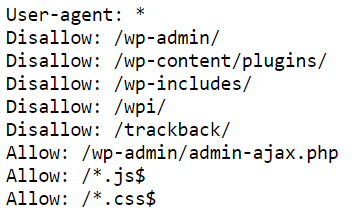

Las carpetas que se suelen añadir al robots.txt son las que se encuentran dentro del administrador, los recursos generados por los plugins… Este es un ejemplo de robots.txt:

Observa que en la imagen se bloquean /wp-admin/ y /wp-includes/, pero dentro de la carpeta /wp-content/ solo marcamos como disallow la subcarpeta /plugins/. De esta forma permitimos que Google indexe el resto de contenido de esta ruta, como las imágenes.

Con archivos robots.txt, puedes bloquear los archivos de recursos (como los de imagen, secuencias de comandos o estilo que no sean importantes) si crees que prescindir de ellos no afectará de forma significativa a las páginas que se carguen sin dichos recursos.

Soporte de Google

Si piensas que bloqueando el acceso de Google a estos recursos estás dificultando su rastreo, no los añadas.

Es el caso por ejemplo de los recursos .js y .css. Google advirtió que debemos permitir su lectura a estos recursos para que pueda realizar un rastreo correcto.

Para asegurarnos de que los pueda leer, añade esto en tu robots.txt:

Allow: /*.js$

Allow: /*.css$

Directivas que componen el archivo robots.txt

User agent

El archivo siempre comienza así para indicar a qué buscador nos estamos dirigiendo con las indicaciones que irán después

Cada motor de búsqueda se identifica con un user-agent diferente:

- Google: Googlebot

- Google Images: Googlebot-Image

- Bing: Bingbot

- Yahoo: Slurp

- Baidu: Baiduspider

- DuckDuckGo: DuckDuckBot

También puedes utilizar un asterisco * para dirigirte a todos los rastreadores

Disallow

Dentro de este campo introduces el las carpetas que deben ser bloqueadas para los rastreadores. Bloquea todo lo que contenga la ruta que le indiques.

Por ejemplo, si quieres bloquear el acceso a tu blog puedes hacerlo de la siguiente manera:

User-agent: * Disallow: /blog

Allow

Esta directiva sirve para permitir a los motores de búsqueda rastreen un subdirectorio o una página, incluso si hemos añadido la ruta en disallow. Por ejemplo, si has bloqueado tu blog pero quieres que una entrada en concreto sí se muestre la puedes añadir de esta forma:

User-agent: * Disallow: /blog Allow: /blog/mientrada

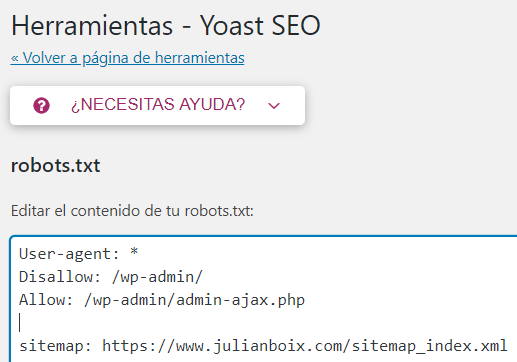

Sitemap

Inserta el sitemap.xml en el archivo robots.txt para que Google lo encuentra fácilmente. Simplemente tienes que indicar la URL donde se encuentra tu sitemap o índice de sitemaps que has subido a Google. En este post explico cómo generar un sitemap.xml.

sitemap: https://www.julianboix.com/sitemap_index.xml

Directivas en conflicto

Si añades una directiva Allow que se contradice con una Disallow, Google hará caso a una e ignorará la otra. Ganará la que más caracteres tenga, por lo que en este ejemplo ganará la directiva Disallow:

Disallow: /blog/ Allow: /blog

Si se diera el caso de que las dos directivas contienen el mismo número de caracteres, ganará la menos restrictiva. En el siguiente caso ganaría la directiva Allow:

Disallow: /blog/ Allow: /blog/

Cómo crear el archivo robots.txt

Podemos crearlo de varias formas, pero voy a empezar por la que más suelo utilizar en mis webs.

Yoast SEO. La forma más rápida de crear el robots.txt

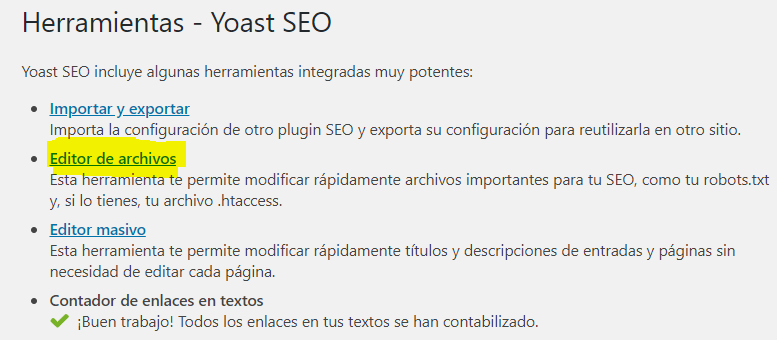

Si te preocupa el robots.txt es porque te interesa el SEO, y si te interesa el SEO tendrás instalado el plugin Yoast SEO. Seguramente lo habrás instalado para modificar tus títulos y descripciones, pero… También puedes modificar el robots.txt con Yoast.

Tan solo tienes que acceder a herramientas y luego a “editar archivos”. Verás que tienes un acceso directo al robots.txt y lo puedes modificar como quieras.

Dentro de esta carpeta se puede modificar el archivo como si fuera un documento de texto:

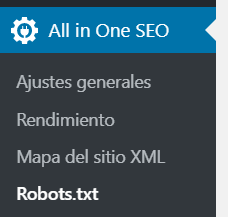

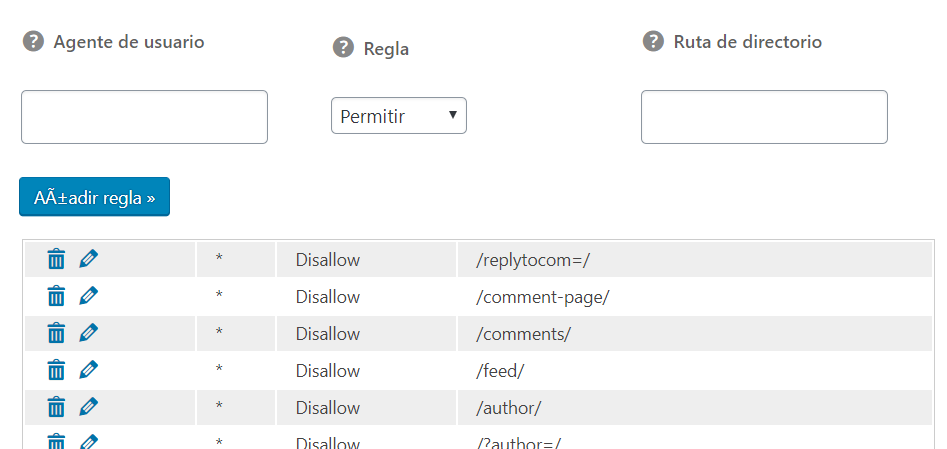

All in One SEO. Modifica el robots.txt rápido.

Aunque también es una forma rápida de modificar el archivo robots.txt, el plugin All in One SEO lo pone un poco más difícil para añadir líneas de código.

No es un editor libre, pero con un poco de paciencia puedes completar línea a línea todas las líneas de código que necesitas.

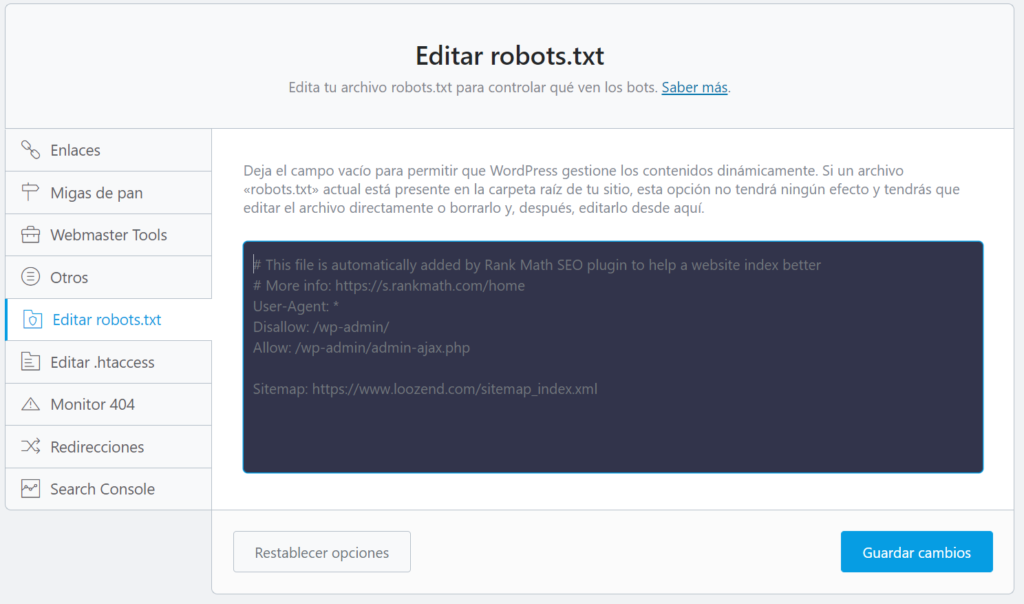

Modificar robots.txt con Rank Math

En este caso tendremos que ir a “ajustes generales” dentro del plugin de Rank Math

Después en “Editar robots.txt” encontraremos el acceso directo al archivo de texto editable. Le damos a “guardar cambios” y ya estaría actualizado.

Es posible que (como se muestra en la imagen) no te permita modificar el archivo debido a que se encuentra en el directorio raíz.

En este caso tendríamos que eliminar el robots.txt accediendo desde el servidor o desde FTP. Una vez hecho esto te permitirá editarlo desde Rank Math.

Si lo dejas en blanco se creará un robots.txt por defecto ya optimizado para SEO, aunque si quieres bloquear el acceso a alguna página puedes editarlo y añadir las directivas que quieras.

De entre todos los plugins, Rank Math es el que más fácil te lo pone para tener un robots.txt optimizado en poco tiempo.

Conclusiones sobre el uso de robots.txt

Recuerda no que Google quiere que desindexes siempre utilizando la etiqueta “noindex”.

Aunque Google no suele indexar las páginas web que están bloqueadas por robots.txt, no es 100% seguro que se desindexe mediante el archivo robots.txt si estos son enlazados desde otras webs o con cualquier otro enlace externo.

No hay que excederse en el uso de los bloqueos, ya que es posible que Google necesite acceder a algunos recursos para comprender correctamente una página.

Si has añadido la etiqueta “noindex” en las páginas que no quieres indexar, no las añadas también en robots.txt. Si haces esto Google no podrá leer la etiqueta “noindex”.

Finalmente, si quieres saber si una ruta está bloqueada o no por robots.txt puedes utilizar la herramienta de pruebas de robots.txt de Google.